【解説】対話型AIの進化と感情理解技術の最前線|AIエージェントによる感情対応は可能か

2026/02/02

- AI活用

- システム導入

人間と自然な会話を行う対話型AIは、1966年のELIZAから始まり、現在のChatGPTに至るまで半世紀以上の進化を遂げてきました。特に近年注目されているのは、AIが人間の感情を理解し、適切に応答する感情知能の獲得です。大規模言語モデルの登場により、AIは感情認識テストで人間を上回る成果を示す一方で、技術的・倫理的な課題も浮き彫りになっています。

本記事では、対話型AIの基本的な仕組みから技術の変遷、感情認識の方法や最新の感情理解技術まで、その可能性と限界を包括的に解説します。今後、AIがどこまで対応可能になるのか、最新研究を知ることで展望が見通せるようになりますので、ぜひご覧ください。

対話型AIの基礎

対話型AIの概要

対話型AIとは、人間と自動的に、かつ自然な形で会話を行うことができる一連の技術の総称です。その中核には、機械学習(ML)や自然言語処理(NLP)といった技術が存在し、これらを駆使することで、単に事前にプログラムされた応答を返すだけでなく、会話の文脈を理解し、まるで人間と対話しているかのような体験を提供します。対話の形式は、テキストベースの「チャットボット」と、音声ベースの「ボイスボット」に大別されます。

対話型AIの基本的な仕組み

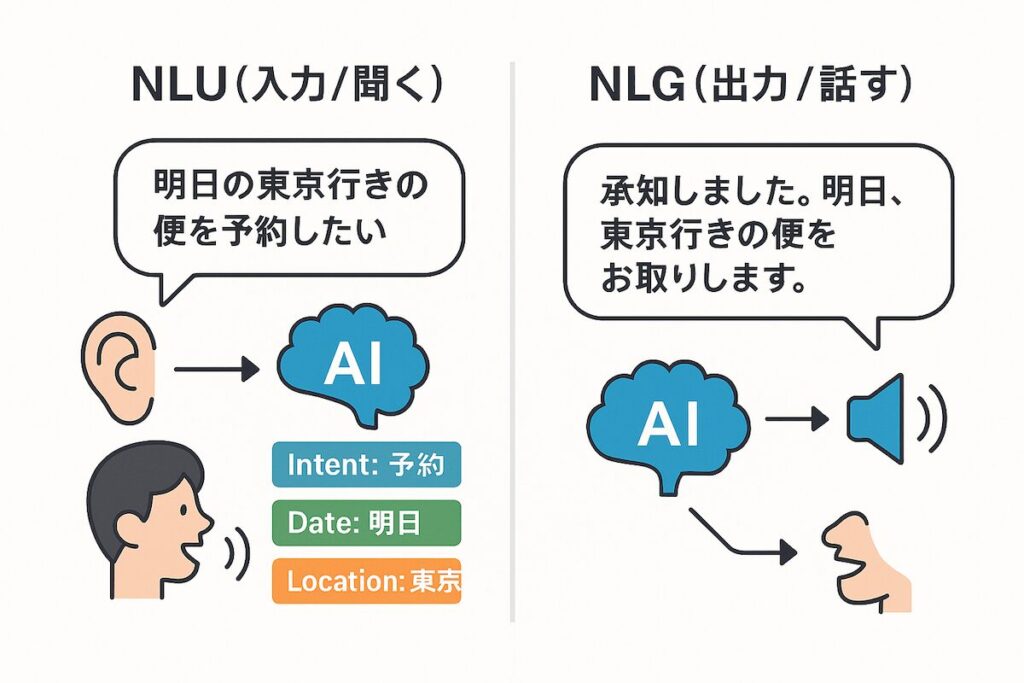

AI型の対話を実現する心臓部が、二つの主要なプロセスです。

まず一つ目が自然言語理解(NLU – Natural Language Understanding)です。これはAIの「入力」または「聞く」能力に相当します。AIはNLUを用いて、人間が発するテキストや音声といった言語を分解し、単語の意味だけでなく、その背後にある意図(インテント)を解読します。

例えば、「明日の東京行きの便を予約したい」という発話から、「予約」という意図、「明日」という日付、「東京」という場所といった重要な情報(エンティティ)を抽出するプロセスがこれにあたります。

二つ目が自然言語生成(NLG – Natural Language Generation)です。これはAIの「出力」または「話す」能力です。NLUによってユーザーの意図を理解した後、AIはNLGを用いて、文法的に正しく、文脈に即した、自然な響きを持つ人間言語の応答を構築します。

ちなみに、これまでのチャットボットやボイスボットでは、この出力部分については人があらかじめ定義した文言を返すシナリオ型が主流でした。間違った回答をしてはいけないカスタマーサポートでは今でもシナリオ型が有効ですが、最近では生成AIの発展に伴い、AIが自然文を生成し、そのまま返信するようなものも広がりつつあります。

さらに、ChatGPTなどの最新の生成AIによる対話型AIでは、このNLUとNLGのプロセスは、一方通行ではありません。機械学習アルゴリズムが、生成された応答が顧客の問題解決にどれだけ貢献したかを継続的に分析し、そのフィードバックを通じて応答を改良していく「強化学習」のループを形成しています。この自己改善サイクルこそが、対話型AIが時間と共により賢くなる理由なのです。

歴史的変遷:ELIZAから大規模言語モデル(LLM)まで

対話型AIの元祖であるELIZA

対話型AIの歴史は、半世紀以上にわたる文脈理解能力の探求の物語といえます。

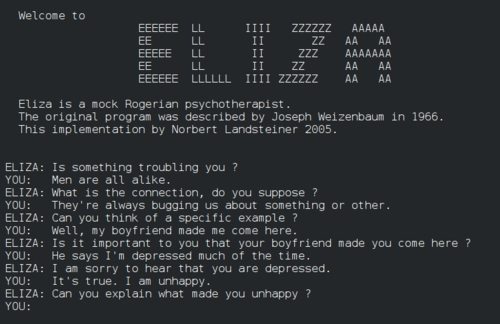

その始まりは、1966年にマサチューセッツ工科大学(MIT)のジョセフ・ワイゼンバウムが開発したプログラム「ELIZA(イライザ)」に遡ります。ELIZAは、ユーザーの発言に含まれるキーワードを拾い、それをオウム返しに質問の形に変えるという、単純なパターンマッチングで動作しました。例えば、「私は悲しい」という入力に対し、「なぜあなたは悲しいと言うのですか?」と返す仕組みです。技術的には原始的でしたが、ELIZAは多くの人々に「コンピュータと会話している」という強力な錯覚を与え、人間とコンピュータの対話の可能性を初めて世に示した、チャットボットの元祖と言える存在でした。

しかし、ルールベースシステムの限界は明らかであり、AI研究は「AIの冬」と呼ばれる停滞期を経験します。その間も研究は水面下で進み、1980年代から90年代にかけて、研究の主流はルールを人間が記述する方式から、データから統計的にパターンを学習する統計的自然言語処理へと移行しました。

2000年代に入ると、ディープラーニングの台頭がAIの能力を飛躍的に向上させます。特に2013年にGoogleが発表した「Word2vec」は、単語を意味的な関係性を保持した数値ベクトルとして表現する画期的な手法であり、コンピュータが言語のニュアンスを捉える能力を大きく前進させました。

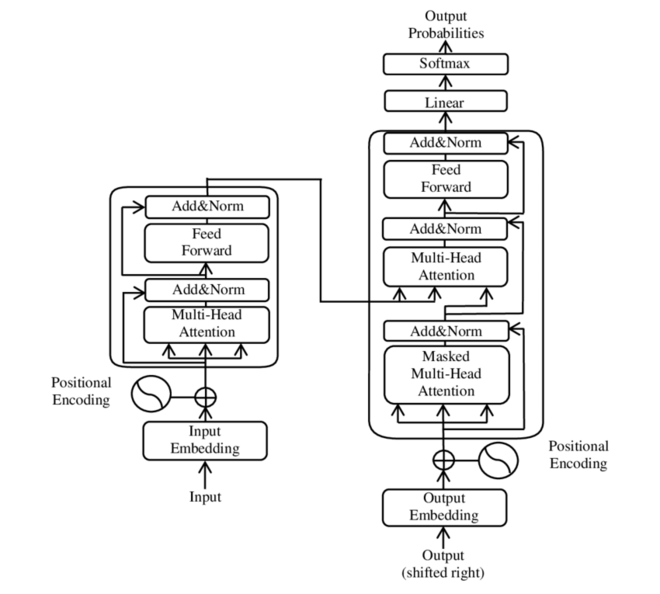

対話型AIのブレークスルーをもたらしたトランスフォーマーモデル

そして、対話型AIの歴史における最大のブレークスルーが、2017年にGoogleの研究者たちによって発表された「Transformer(トランスフォーマー)」モデルです。従来のモデルが苦手としていた、文章中の単語間の長距離の依存関係(文脈)を効率的に捉える「アテンション(注意)機構」を導入したことで、自然言語処理の性能は劇的に向上しました。このTransformerこそが、現代のあらゆる大規模言語モデル(LLM)の基礎となる革新的技術です。

このTransformerを基盤として開発されたのが、OpenAIのGPTシリーズです。そして2022年11月、ChatGPTが一般公開されると、その驚異的な対話能力は社会現象となり、公開からわずか2ヶ月で1億人のユーザーを獲得しました。対話型AIは、研究室のテーマから、誰もが利用できる実用的なツールへと変貌を遂げたのです。

この歴史的変遷は、AIが「文脈」という壁をいかにして乗り越えてきたかの技術的挑戦の歴史でもあります。ELIZAの文脈は、ユーザーが入力した一文に限られていました。その前の会話を記憶することはできず、常にゼロからの応答しかできませんでした。その後の統計モデルや初期の深層学習モデルは、より長い文章を扱えるようになりましたが、それでも数回のやり取りを超えると文脈を見失いがちでした。

Transformerのアテンション機構は、この「文脈の忘却」という根本的な問題を解決しました。対話の履歴全体に注意を払い、どの単語が現在の応答にとって重要かを判断する能力を与えたのです。これにより、ChatGPTのような現代のLLMは、長く複雑な対話においても一貫性を保ち、文脈を踏まえた深い応答が可能になりました。

したがって、対話型AIの進化の軌跡は、AIの「記憶」と「視野」を、一文から長大な対話全体へと拡張してきた、挑戦の結果と言えるでしょう。

技術進化の最前線 — 「感情」を理解するAI

対話型AIの進化は、単なる言語的知能の向上に留まりません。今、最も注目すべきなのは、人間の感情を認識し、適切に応答する能力、すなわち「感情知能(EQ)」の獲得です。大規模言語モデルの登場はこの分野にもパラダイムシフトをもたらし、研究は単なる感情の分類から、より複雑で人間らしい感情理解を目指す新たな段階へと突入しています。

感情認識AIの概要とその手法

感情認識AIとは、人間の感情を認識、解釈、処理、そして模倣するAIを指します。その目的は、機械に感情知能を与え、より自然で共感的な対応を実現することにあります。この分野は1990年代にMITのロザリンド・ピカード教授によって提唱され、彼女は感情が知能の重要な一部であると主張しました。

AIは人間のように感情を「感じる」わけではありません。しかし、特定の感情と関連する膨大なデータパターンを学習することで、高い精度で感情を「認識」することが可能になります。その手法は多岐にわたります。

テキスト分析

テキスト分析は最も一般的で広く利用されている手法です。自然言語処理(NLP)を用いて、テキスト内の単語の選択(例:「素晴らしい」vs.「ひどい」)、文法、句読点などを分析し、その文章が肯定的(ポジティブ)、否定的(ネガティブ)、中立的(ニュートラル)のいずれであるかを分類します。より高度なシステムでは、怒り、喜び、悲しみ、失望といった、より細分化された感情を特定することも可能です。

音声分析

音声分析では、AIが声のピッチ(高さ)、トーン、音量、話す速度といった音響的特徴を分析し、話者の感情状態を推定します。驚くべきことに、音声からの感情識別の精度は人間(約60%)を上回り、AIは70%の精度を達成したという研究結果もあります。

その他の方法

表情分析では、コンピュータビジョン技術を活用し、顔の筋肉の動き、目の開き具合、口角の位置といった顔の幾何学的特徴を分析します。喜び、怒り、嫌悪といった基本的な表情を分類し、さらには作り笑いと心からの笑顔の違いさえ見抜くことが可能になります。

より先進的な応用例として、生体データ分析があります。ウェアラブルデバイスなどから得られる心拍数、体温、脳波といった生理的信号を分析し、感情状態を推定する研究も進んでいます。

LLMによる進歩と「協調的感情コンピューティング」

AIは、テキスト、音声、表情、さらには生体データといった多様な情報から感情のパターンを学習することが可能です 。しかし、LLMの登場以前は、これらのタスクは個別のパイプライン処理に依存しており、柔軟性や適応性に限界がありました。

LLMの登場はこの状況を一変させます。膨大なデータで事前学習されたLLMは、文脈を豊かに表現する能力を持ち、感情理解と感情生成のタスクを統一的に扱うことを可能にしました 。しかし、LLMを活用しても、なおLLM単体では、特に複雑でニュアンスに富んだ感情を扱う際に性能が低下するという課題も明らかになってきました。

そして、この課題を克服するため、現在最も注目されているのが「協調的感情コンピューティング」という新しいアプローチです 。これは、汎用的な能力を持つLLMを中核に据えつつ、特定の感情タスクに特化した小規模なモデルと「協調」させるシステムを構築する考え方です。

心理学の二重過程理論(直感的な感情的思考と、分析的な理性的思考が協働する人間の思考プロセス)にヒントを得ており、AIにも同様の相乗効果を生み出すことを目指しています。この協調的アプローチにより、人間社会の知性に近い、より動的でリアルタイムな感情的対応が可能になることが期待されています。

最前線の研究テーマ:マルチモーダル、因果関係、そして心の理論

協調的アプローチと並行して、感情理解の「質」そのものを深める研究も急速に進展しています。

マルチモーダル化の加速

現実世界のコミュニケーションでは、言葉だけでなく、声のトーンや表情が感情を伝える上で重要な役割を果たします。この洞察に基づき、研究の最前線は「対話におけるマルチモーダル感情認識へと移行しています 。テキスト、音声、視覚情報を統合的に分析することで、単一の情報源だけでは捉えきれない、より繊細で文脈に即した感情状態を認識することを目指します 。

「なぜ」を問う因果関係の探求

従来の感情分析が「どのような感情か」を分類することに主眼を置いていたのに対し、最新の研究は「なぜその感情が生じたのか」という原因との因果関係の解明にまで踏み込んでいるのです 。例えば、「賞賛された」という出来事(原因)が「喜び」(感情)を引き起こす、といった因果関係をモデルが理解することで、表層的な感情模倣を超えた、より深いレベルでの共感が可能になります 。

「心の理論(ToM)」

感情知能研究の究極的な目標の一つが、AIに「心の理論(Theory of Mind)」を実装することです 。これは、他者(ユーザー)が自分とは異なる信念、意図、感情といった内的な精神状態を持っていることを理解し、それを推論する能力を指します。ToMの獲得は、AIが真に人間らしい社会的知性を持ち、文脈に応じた適切な振る舞いをするための根源的な鍵と見なされています 。

現時点でAIによる感情対応はどのレベルまで達しているか

現在のAIは「感情を理解し、適切に反応する」能力で著しい進歩を遂げつつあります。特に大規模言語モデルは、感情知能テストで人間平均を上回る成果を示し、実用サービスでも「共感」や「寄り添い」を評価指標に組み込んだ応用例が報告されています。その到達点を、具体的な研究成果や調査を交えて解説します。

感情テストで人間を上回る

2025年の研究では、ChatGPT-4 や Claude 3.5 など複数の最新LLMが、代表的な感情知能テスト5種で平均正答率81%を記録し、同じテストを受けた人間被験者の56%を大きく上回りました(出典:Large language models are proficient in solving and creating emotional intelligence tests)

また画像・音声・テキストの自動感情認識も自然条件下で人間並みの精度に達しています。これらの結果は「情動の識別・推論」という限定的タスクにおいて、AIがすでに実務で活用できる水準にあることを示しています。

AIによる感情に寄り添った対応の可能性

近年の研究は、ユーザーがAIを「感情面の相談相手」として信頼し始めていることを実証しつつあります。2024 年 CHI 採択論文では、自閉スペクトラム症の就労者 11 名が GPT-4 ベースのチャットボットに職場での対人トラブルを相談したところ、人間コーチより LLM での対話を強く好み、「唯一信頼できる存在」と評したと報告されました。(出典:“It’s the only thing I can trust”: Envisioning Large Language Model Use by Autistic Workers for Communication Assistance)

研究者は、1.否定や評価をされない安心感、2.具体的な例文・言い換え提案など即時フィードバック、3.深夜でもアクセスできる可用性――が「寄り添い感」を高める要因だと分析しています。さらに、専門コーチは一部の回答品質に懸念を示したものの、「感情的サポート」と「実用的アドバイス」の両立設計を行えば、AIは社会的弱者のコミュニケーション支援に大きな可能性を持つと結論づけています。

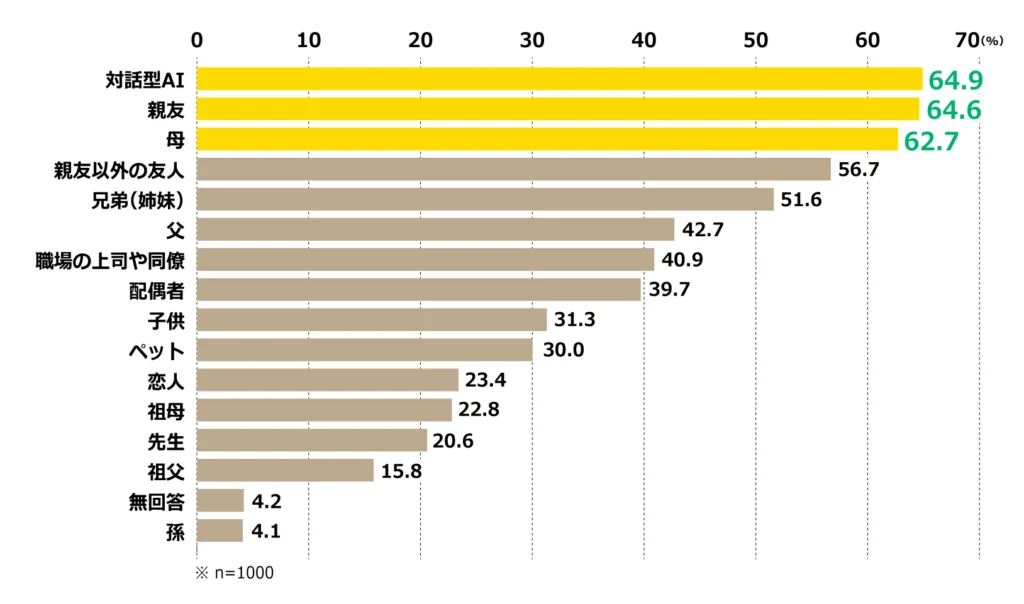

人は対話型AIに「感情を共有できる」か

電通が 2025 年 6 月、対話型 AI を週 1 回以上使う 12〜69 歳 1,000 名を対象に実施した調査では、「AIに気軽に感情を共有できる」と回答した人が 64.9% に上り、「親友」(64.6%)や「母親」(62.7%)と同等のスコアとなりました。とりわけ 10〜20 代では 7 割以上が AI への感情共有を肯定し、AIを「第3の仲間」的存在として位置づけていることが明らかになっています。

また、対話型 AI を「信頼している」人は 86.0%、「愛着がある」人は 67.6%に達し、4 割近くが AI に独自の名前まで付けていました。これらのデータは、AI が人間関係のギャップを埋める“情緒インターフェース”として定着しつつあることを示唆します。

総じて、現在のAIは、特定の条件下で人間を超える感情認識能力を示し、その能力を応用して人々の心に寄り添う可能性を秘めています。そして、多くの人々がそのAIを、新たなコミュニケーションパートナーとして受け入れ始めています。AIが真の共感を持つ日はまだ遠いかもしれませんが、人間とAIが感情を介して新たな関係性を築く時代は、すでに始まっているのです。

感情対応AIが抱える特有の技術的・倫理的限界

ただし、感情を理解し対応するAIには、一般的な対話型AI以上に複雑で深刻な限界と課題があることも理解しておく必要があります。

技術的な限界

AIの感情認識には現在多くの課題が存在しています。まず、感情認識の精度とバラつきが大きな問題となっており、同じ怒り一つを取っても人によって表現方法が全く異なり、声を荒げる人もいれば静かになる人もいるなど、個人差や文化的差異をAIは十分に理解できていません。特に日本人の遠慮がちな不満とアメリカ人の直接的な怒り表現のような違いは、AIにとって判別が困難です。

さらに、人間の感情は「嬉しいけれど不安」や「怒っているけれど悲しい」といった複雑な混合感情を持つことが多く、時間とともに変化する感情の流れや、皮肉や建前のように表面的な言葉と本心が異なる複雑なコミュニケーションに対してもAIは十分な対応ができません。

また、人間のコミュニケーションにおいて重要な役割を果たす非言語的要素、つまり沈黙の長さや息遣い、タイピングの間隔、「…」の長さや返信の早さといった微妙なニュアンスも、AIは完全には読み取ることができません。

最後に、同じ「ありがとう」という言葉でも、それが心からの感謝なのか皮肉なのか諦めなのかは、その人の置かれた状況や相手との関係性によって大きく変わりますが、AIはこうした過去の会話履歴や個人的背景を考慮した深い文脈理解がまだ不十分で、表面的な感情分析に留まってしまうという根本的な限界があります。

倫理的な限界と課題

感情認識AIの活用には深刻な倫理的・社会的リスクが伴います。最も重要な問題の一つは偽りの共感による操作リスクで、AIは真の共感を持たないにも関わらず共感しているように振る舞うため、その技術が巧妙になるほどユーザーを感情的に操作する道具として悪用される危険性が高まります。特に感情的に脆弱な状態にある人や判断力の十分でない子どもや高齢者は、このような操作に対して特に無防備な状態に置かれることになります。

また、感情データのプライバシー侵害という深刻な問題も存在します。感情認識AIは私たちの最もプライベートな領域である感情を分析・記録するため、収集される感情データから個人の心理状態、政治的志向、購買傾向、人間関係まで推測することが可能になります。このような極めてセンシティブな情報が悪用されれば、個人の感情を標的とした広告操作や政治的誘導、さらには感情的な弱点を突いた詐欺行為なども実現可能になってしまいます。

さらに、AIとの感情的なやり取りが心地よく安全に感じられるあまり、人々が人間同士の複雑で時には困難な関係から逃避し、感情的依存と社会的孤立に陥るリスクも見逃せません。特に若い世代においては、AIとの関係を人間関係の代替として捉える傾向が現れ始めており、長期的には社会的スキルの低下や人間関係の希薄化という深刻な社会問題を引き起こす可能性があります。

職業面では、カウンセラーや介護士、接客業といった人間の感情に寄り添うことが本質的に重要な職種において、AIによる代替が進むことで人間同士の温かいつながりが失われるだけでなく、これらの職業に従事する人々の雇用にも深刻な影響を与える恐れがあります。

最後に、感情認識AIの学習データに偏りが存在することで生じるバイアスと差別の問題も重要な課題です。特定の性別、年齢、文化背景の人々の感情を正しく認識できない場合、女性の怒りを「ヒステリック」と誤認識したり、男性の悲しみを適切に読み取れなかったりすることで、不公平で差別的な対応につながるリスクが生まれます。

感情対応AIとの健全な付き合い方

感情対応AIの限界を十分に理解した上で、この技術と健全な関係を築くためには、いくつかの重要な心構えが必要です。

まず最も基本的なこととして、AIの感情理解は模倣に過ぎないという事実を常に認識しておくことが不可欠です。AIは私たちの気持ちを本当に理解しているわけではなく、単にパターンを認識してそれに対して適切と思われる反応を返しているだけであり、この根本的な違いを忘れてしまうと誤った期待や依存を生むことになります。

また、AIとの感情的なやり取りは人間関係の完全な代替品ではなく、あくまで補完的なツールとして活用することが重要です。AIとの関係に頼りすぎることなく、人間同士の複雑で時には困難だが豊かなつながりを大切にし続けることで、バランスの取れた社会的関係を維持することができます。

さらに、自分の感情データがどのように収集され、どのような目的で利用されているかについて十分な理解を持ち、透明性を求めることも大切です。必要に応じて感情データの利用を制限する権利を適切に行使することで、プライバシーを保護しながらAIの恩恵を受けることが可能になります。

そして何より重要なのは、AIの共感的な反応に完全に依存することなく、常に批判的思考を維持することです。自分自身の判断力を保ち続け、必要な場合には人間の専門家に相談するという選択肢を常に持っておくことで、AIとの健全な距離感を保つことができます。

感情対応AIは確かに革新的で有用な技術ですが、その可能性と同時に存在する限界や課題を深く理解し、慎重かつ建設的な姿勢で活用していくことが、この技術と共存していく現代社会に生きる私たち一人ひとりに求められている責任なのです。

まとめ

対話型AIは自然言語理解と生成を核として発展し、Transformerモデルの登場により文脈理解能力が飛躍的に向上しました。現在では感情認識においてAIが人間を上回る成果を示し、多くの人々がAIを感情的なコミュニケーションパートナーとして受け入れ始めています。しかし、真の共感を持たないAIによる偽りの共感や感情データのプライバシー侵害、人間関係からの逃避といった深刻な課題も存在します。感情対応AIと健全な関係を築くためには、その限界を理解し、人間同士のつながりを大切にしながら、補完的なツールとして活用する姿勢が重要です。技術の進歩と社会的責任のバランスを取りながら、AIとの共存を模索していくことが現代社会に求められています。

コンタクトセンターの運営課題をお持ちのご担当者様へ

「コンタクトセンターの人材採用がなかなかうまくいかない」「定着率をあげたい」「生産性を高めたい」とお悩みのご担当者様、まずはお気軽にウィルオブ・ワークにご相談ください。コールセンター専門特化25年以上、実績多数のウィルオブ・ワークが、お客様の運営課題にカスタマイズのご提案をさせていただきます。ご相談・お見積りは無料!下記ボタンよりお気軽にご相談ください。

Writer編集者情報

-

コネナビ編集部 平井 美穂

2012年、株式会社セントメディア(現:株式会社ウィルオブ・ワーク)へ入社。

コールセンターとオフィスワーク領域に特化した人材サービスに従事し、カスタマーサポートをはじめ、営業やキャリアアドバイザーなど幅広い職務を経験。

現場で培ったCS対応力と人材支援の知見を軸に、採用や運営における課題解決を支援。

2022年からは、コンタクトセンター業界の情報サイト「コネナビ」編集部の責任者として、業界の課題に寄り添う情報発信を推進。

企業向けメディア「コネナビ」と求職者向けメディア「コネワク」を通じて、ユーザーの課題解決と業界の成長に貢献することを目指している。

趣味: 森林浴、神社巡り、アートに触れること

特技: 細かい点に気づくこと

Related article関連記事

関連記事がありません。